近年、生成AIや大規模言語モデル(LLM)の活用が急速に普及し、専門家だけでなく一般ユーザーや開発者にとってもローカル環境でAIを試したいニーズが高まっています。

【2025】“今”注目のローカルLLMを深掘り!

一方で、従来はNVIDIA GPU搭載のWindows自作PCが主流でしたが、Appleシリコン搭載のMacはユニファイドメモリや省スペース設計、シンプルなセットアップといった独自の強みを持っています。そのため、プライバシー重視の個人利用や、手軽かつ静音で最新LLMを試したいユーザー層から、「MacでLLMを動かす」という選択が注目されるようになっています。これにあわせてMac対応のツール群も充実し、自分のPCで高性能AIを活かす新たな時代が始まっています。

MacでLLMを使うメリットMacでLLMを動かす魅力

- ユニファイドメモリの強み

Appleシリコン(Mシリーズ)はCPUとGPUで共通して大容量高速メモリを使える設計。これにより、コンシューマ向けNVIDIA GPU(例:VRAM24~32GB)に比べて、より大きなモデルも安定して動かせます。 - 手軽な導入と省スペース

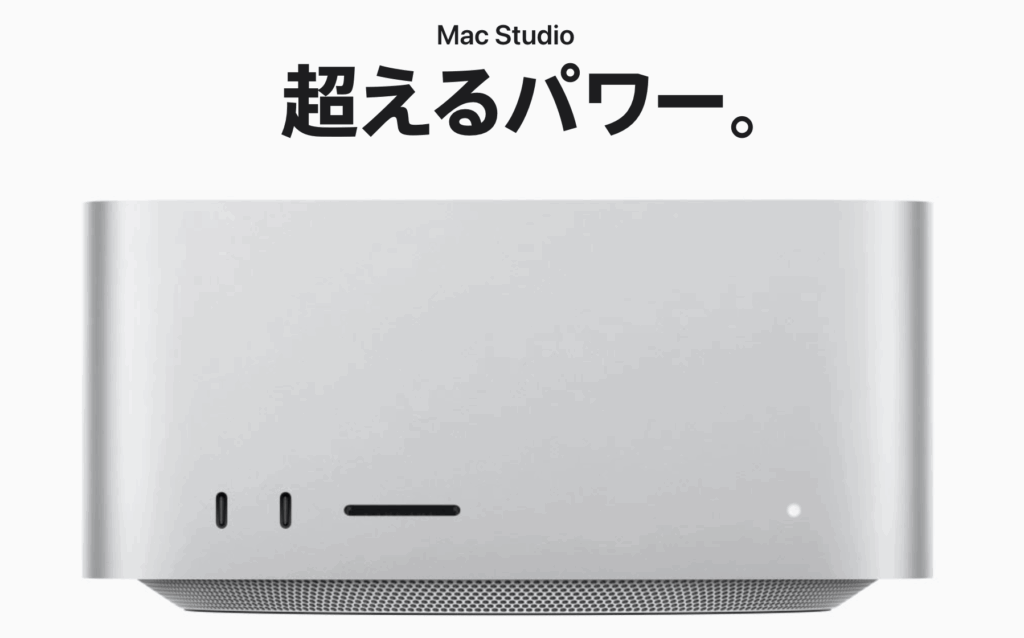

NVIDIA搭載Windows自作PCに比べ、設置・配線やドライバ管理などの手間が少なく、「買ってそのまま」使いやすい。Mac StudioやMac miniなら静音・省スペースも実現できます。 - 活発なツール・ソフト対応

LM StudioやOllama、MLXなどMac対応のLLMフレームワークが増加中。PyTorch, TensorFlow, JAX, MLX もMetalサポートでApple GPUの性能を引き出せます。 - ローカル運用の利点

入力内容が外部に漏れない、APIレート制限無し、オフライン動作などプライバシーや可用性面でもメリットが明確です。

デメリットも現実的に知りたい人へ

- GPUの学習用途はまだ制限あり

NVIDIAのCUDA搭載PCに比べ、LLMの「トレーニング(学習)」自体はまだ不得意、または対応状況が限定的。LLMの「推論(質問応答や文生成)」が中心になります。 - 対応モデルの上限

Appleシリコン(M4/M3など)の場合、おおむね13B~32Bクラス程度までなら快適。72Bクラスは動作できるが速度・安定性は限定的。一般的な用途や開発なら十分ですが、研究や巨大モデルの訓練には向きません。 - 価格面とVRAM性能

メモリを重視してBTOしたMac Studioの値段はかなり高額(最大で150万円以上も)。VRAM(ビデオ専用メモリ)重視ならNVIDIA自作PCの方がコスパがよい場合も。

どんな人・用途におすすめ?

- おすすめ

- LLMの「推論」や軽いファインチューニング中心の開発者・検証者

- オフラインやプライバシー重視の個人利用・中小規模事業者

- セットアップや運用の手軽さ、トラブルの少なさを優先したい人

- 非推奨

- LLMの大規模な学習・研究用途

- 100B超の特大モデルをガンガン使いたいパワーユーザー

実際の開発・導入例

- Mac mini M4 Pro(64GB)は14B, 32Bモデルで快適、72Bは実用性ギリギリ

- Mac Studio 96GBや192GB、M3 Ultraは最大512GBメモリ搭載可能で、32B超をローカルで動かせる。ただし費用対効果は要検討

- LM Studio, MLX, Ollama等で最新の軽量・量子化LLMを動かせる

まとめ:現代のAIライフにMacという選択肢

「推論中心」「手軽さや安全重視」ならMacは非常に優秀です。一方、LLMの研究や巨大規模モデル・学習にはNVIDIA PCが依然として王道ですが、「ローカルで手軽にLLM!」という現代的用途にはMacが急速に存在感を増しつつあります。

「迷ったら、一歩進んだ未来のAI体験をMacで手軽に始めてみましょう!」